mysql大数据怎么批量删除和批量插入?

使用mysql的批量导入。source工具导入。

把这些数据分段写成sql进行导入,一亿条分10段,每段1千万

估计每段的导入时间会在五分钟左右。

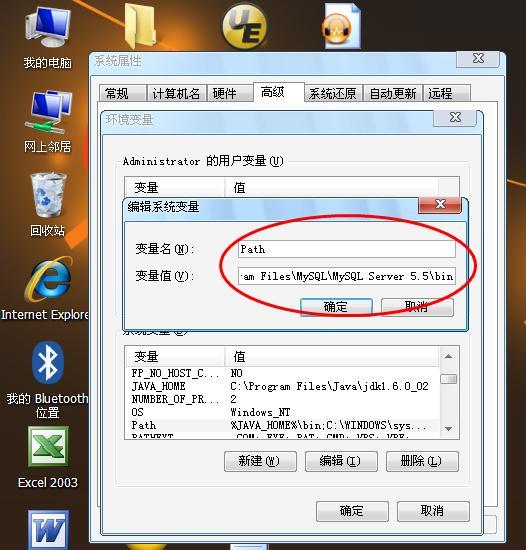

编辑器使用editplus这种工具,否则打不开这么大的文件文件。

图片来源:网络

生成sql,就使用excel自动生成,或者批量查找替换就可以

在本机尝试一下,成功后导出这些sql,然后在正式环境操作。

Mysql能处理多大的数据量?

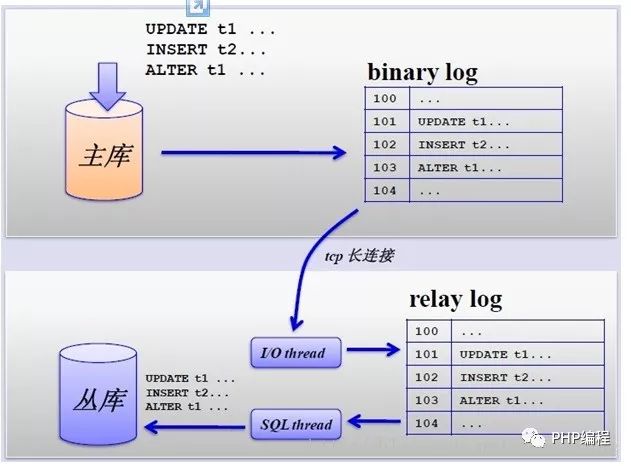

谢谢邀请,理论上MySQL对数据库本身的容量不会做容量方面的限制。具体这个要看你的数据库用什么存储引擎了,这里以常见的MyISAM,Innodb为例。MyISAM不对它的数据文件的大小做任何限制,文件的大小取决于操作系统对每个文件系统单个文件大小的限制。

innodb就不同了,MySQL对每个表空间的大小限制是64T。每个表空间可以有一个或者多个文件,单个文件的大小同样取决于操作系统,但总体同一表空间中所有文件的总和不能超过64T。

mysql批量入库最佳条数?

最佳的批量入库条数并没有一个固定的标准,它取决于多个因素,如服务器性能、网络延迟、数据复杂度等。

一般来说,批量入库的条数应该在100-1000之间,这样可以在保证较高性能的同时,避免数据库负载过高。

如果数据量较小,可以选择较小的批量入库条数;如果数据量较大,可以适当增加批量入库的条数,以提高效率。

此外,还建议在批量入库过程中使用事务方式操作,这样可以保证数据的一致性和完整性,并提高数据入库的效率。