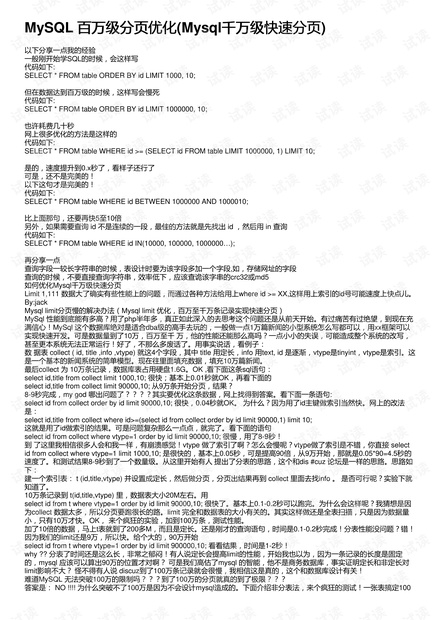

如何优化Mysql千万级快速分页,limit优化快?

select * from collect where id in (9000,12,50,7000); 竟然 0秒便可以查完!id in (str) 很快,根基还是0秒。若是这样,千万级的数据,mysql应该也很轻易应付。

高效的mysql分页方法及原理?

一,最常见MYSQL最基本的分页方式:

select * from content order by id desc limit 0, 10

在中小数据量的情况下,这样的SQL足够用了,唯一需要注意的问题就是确保使用了索引。随着数据量的增加,页数会越来越多,查看后几页的SQL就可能类似:

select * from content order by id desc limit 10000, 10

就是越往后分页,LIMIT语句的偏移量就会越大,速度也会明显变慢。

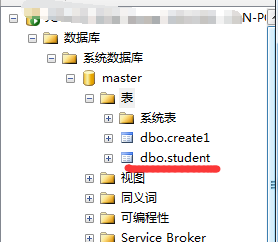

图片来源:网络

此时,可以通过2种方式:

一,子查询的分页方式来提高分页效率,飘易用的SQL语句如下:

SELECT * FROM content WHERE id> (SELECT id FROM content ORDER BY id desc LIMIT ".($page-1)*$pagesize.", 1) ORDER BY id desc LIMIT $pagesize

为什么会这样呢?因为子查询是在索引上完成的,而普通的查询时在数据文件上完成的,通常来说,索引文件要比数据文件小得多,所以操作起来也会更有效率。(via)通过explain SQL语句发现:子查询使用了索引!

id select_type table type possible_keys key key_len ref rows Extra

1 PRIMARY content range PRIMARY PRIMARY 4 NULL 6264 Using where

2 SUBQUERY content index NULL PRIMARY 4 NULL 27085 Using

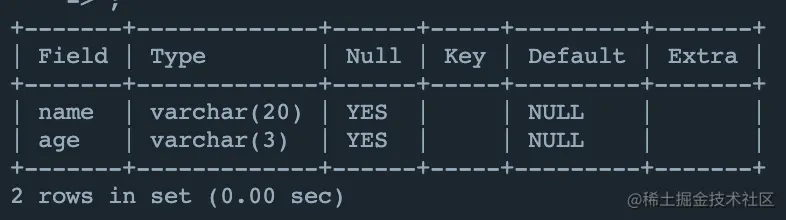

首先看一下分页的基本原理:

复制代码 代码如下:

mysql> explain SELECT * FROM message ORDER BY id DESC LIMIT 10000, 20G ***************** 1. row ************** id: 1 select_type: SIMPLE table: message type: index possible_keys: NULL key: PRIMARY key_len: 4 ref: NULL rows: 10020 Extra: 1 row in set (0.00 sec)

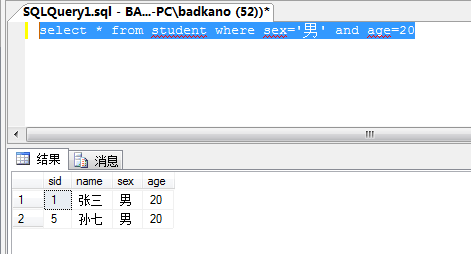

mysql一对多关联查询分页错误问题的解决方法?

对于数据不多的分页..可以用limit

select*fromtablelimit(20,20)

表示从第20行开始..向后移动20行..就是你说的相当于第20行到第40行..同理从第40行到第90行就是limit(40,50)