本地部署DeepSeek该选哪个版本?网上的说法太多,并且挺唬人的,一方面好像没特别好的显卡就搞不了?另一方面又有人把它部署到NAS上,千奇百怪,最后各位小伙伴不得不亲自尝试去摸索。

经过菜菜对7b和14b两个版本的部署和观察,找到了一些规律分享给大家,从技术方面可能会表述不严谨,但是从实践方面却非常有用!

先说结论:要对比的两个“数字”,第一是你显卡的显存大小,第二是你选择的本地模型体积大小。

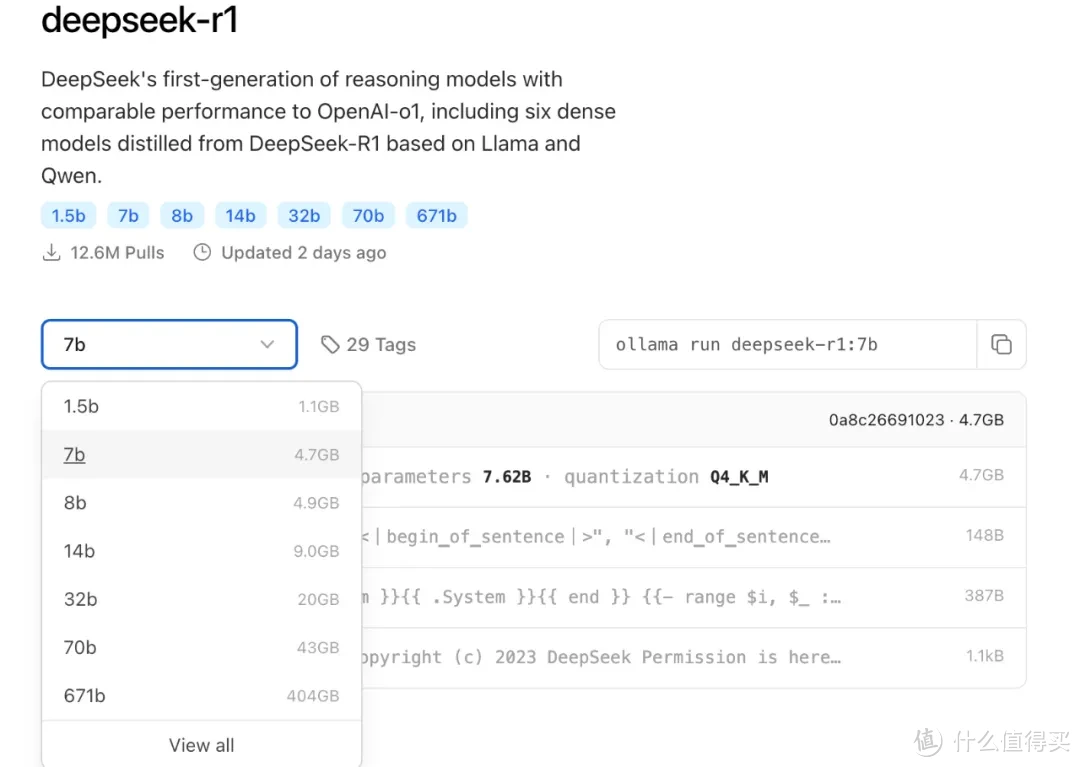

比如我本地是一个12代i5主机,32GB的内存和一个2060独显,6GB显存。看上图,7b版本model的体积是4.7GB,而8b版本model文件体积是4.9GB。

因为“显存”大于“模型”,所以运行时候,可以把模型全部塞进显存里,这时候提问和输出答案的速度就是最快的。这是观察所得的答案,表述可能不准确,实测确实是这么回事。

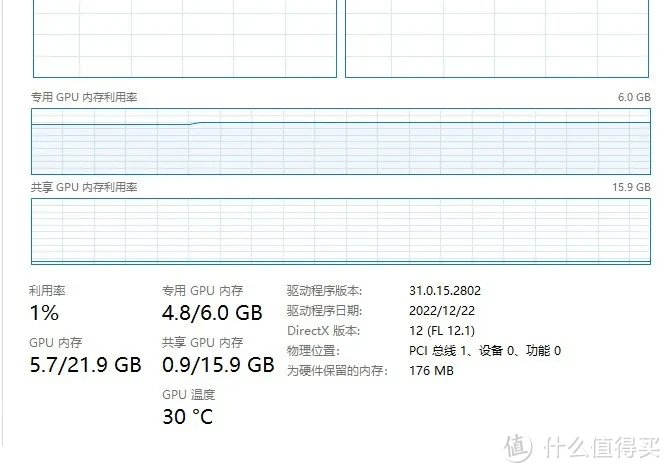

下图就是7b本地模型运行时候任务管理器的表现,可以看到,6GB的显存占用了4.8GB,共享GPU内存占用了不到1GB,GPU内存显示21.9GB,使用时5.7GB。专用GPU内存加上共享GPU内存(向内存借的)等于GPU内存。

当Model文件小于你显卡显存的时候,借内存的那部分用不上,只是在预备着,以防万一。

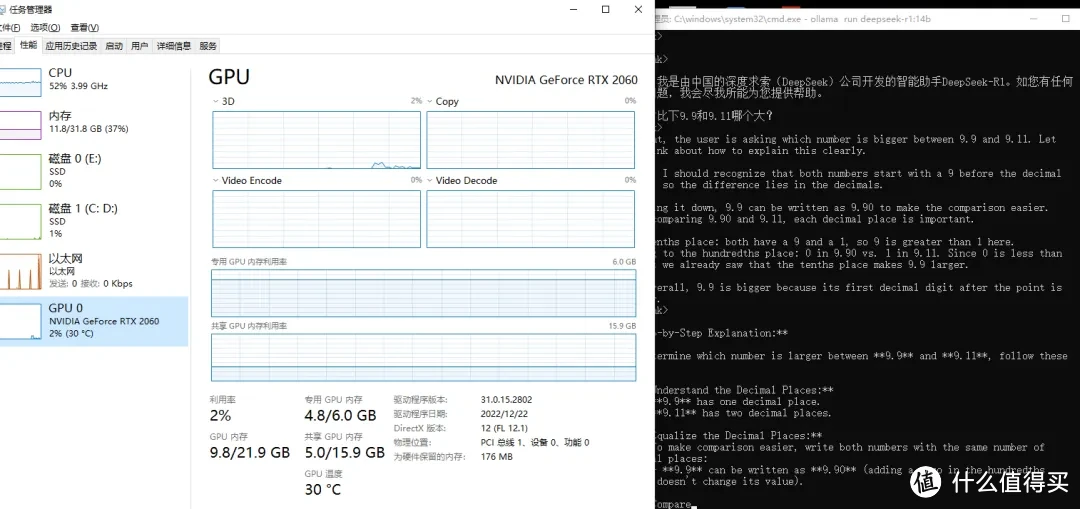

当我本地部署14b版本时候,14b版本的Model文件有9GB,比我的显存还要大,这时候,显存占用4.8GB,向内存借来的16GB里,占用了5GB。只要向内存借用了,CPU也得使劲,此时CPU占用率达到55%左右(见文末最后一个图)。

大家一定注意到了,文章只提及了显存,没提及显卡,毕竟8GB的显存,既有几百块能买到,也有近万元才能买到的。难道真没差别?有一位值友这么说的:“这种已经训练完成的模型,运行速度主要就是看显存,GPU压力很低,显存基本吃满。”

总结:如果你显存有6GB或者8GB,运行7b或者8b版本,速度会比较流畅,放心使用。如果这个显存,你非得上14b,只要你的cpu比较新,内存足够大,也可以用,输出速度和阅读速度相当,勉强能接受。运行14b和7b时候究竟有多快?多慢?查看我最近一个笔记视频,那是原速展示。

作者声明本文无利益相关,欢迎值友理性交流,和谐讨论~

本文来自:什么值得买