最近大火得deepseek,相信很多小伙伴都有体验,比国外得gpt得回复逻辑更适合我们日常使用,而且没有那么复杂得提问逻辑,简单高效使用,从英伟达股票下降15%也可以看出deepseek确实有超过GPT得趋势,资本是最敏感得。

同时因为日活人数大,服务器承受不了,现在每人每天只能问2次,后面就是服务器繁忙,为了限制使用量,避免服务器压力太大,毕竟全球得热度都非常高。

同时本地部署就是一个很好得选择,但是对电脑得配置有一定得要求,对付日常使用足够了,如果是要求比较高还是用官网得回复会更全面。

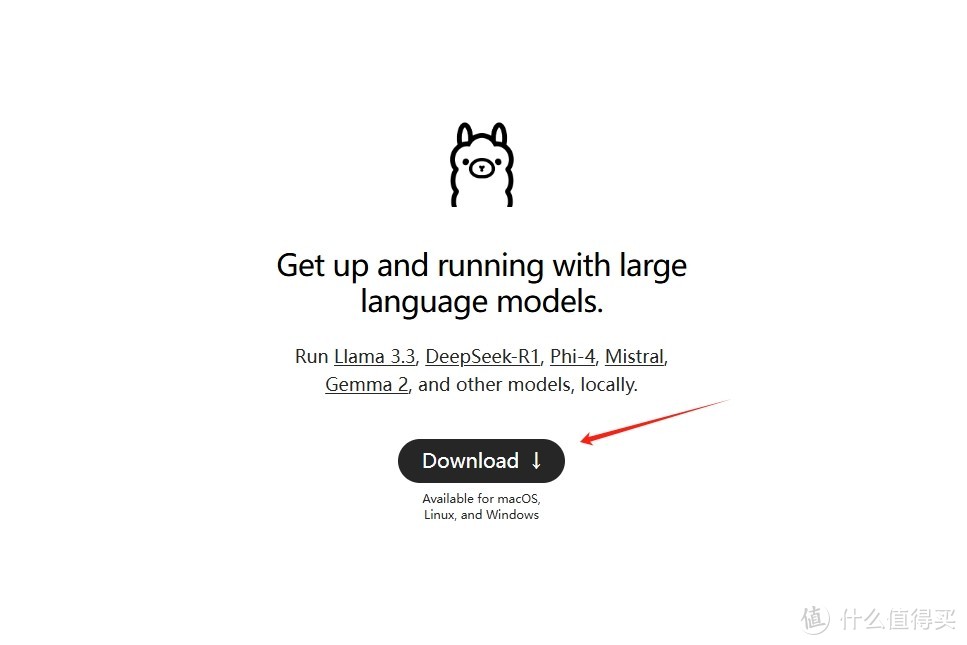

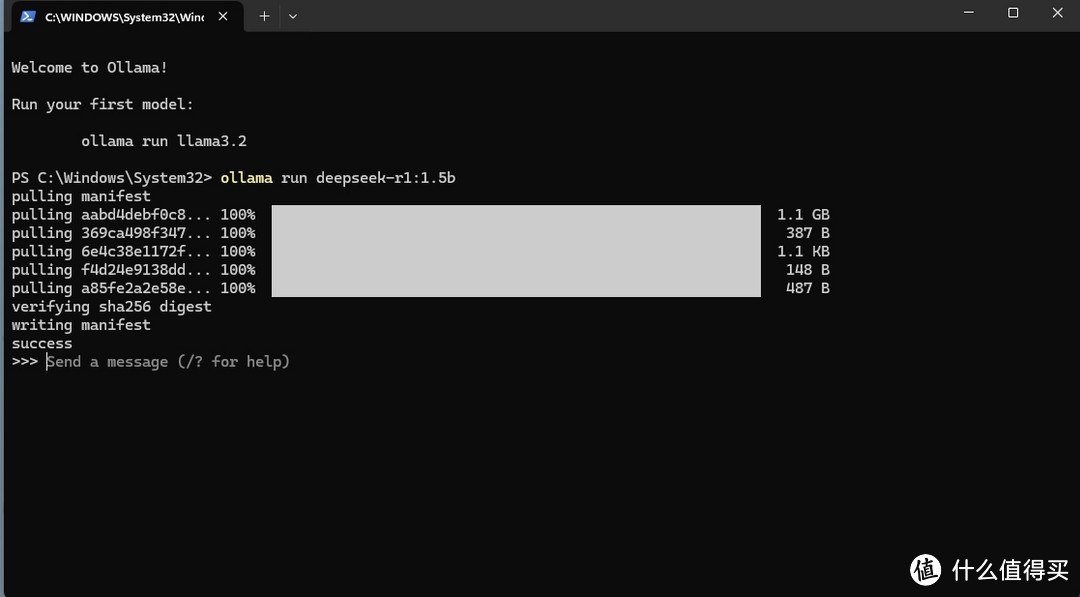

本地部署先去Ollama官网下载软件,并安装,这里安装得时候是没办法选择文件夹路径得,空间需要预留5G左右

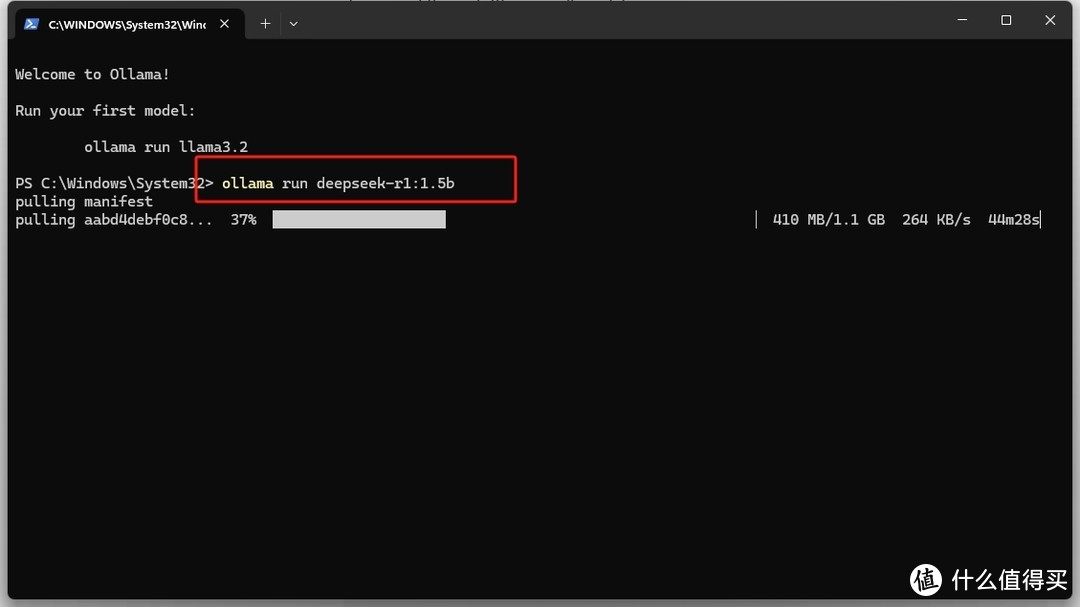

安装完成后开启终端,输入命令,根据自己显卡得大小来选择

没有GPU:1.5B Q8推理 或者 8B Q4推理

4G GPU:8B Q4推理

8G GPU:32B Q4推理 或者 8B Q4推理

16G GPU:32B Q4推理 或者 32B Q8推理

24G GPU: 32B Q8推理 或者 70B Q2推理

1.5B Qwen DeepSeek R1

安装命令 ollama run deepseek-r1:1.5b

7B Qwen DeepSeek R1

安装命令 ollama run deepseek-r1:7b

8B Llama DeepSeek R1

安装命令 ollama run deepseek-r1:8b

14B Qwen DeepSeek R1

安装命令 ollama run deepseek-r1:14b

32B Qwen DeepSeek R1

安装命令 ollama run deepseek-r1:32b

70B Llama DeepSeek R1

安装命令 ollama run deepseek-r1:70b

win+R 运行,敲cmd命令打开终端

粘贴命令,回车等待下载模型,这里根据网速和模型大小,时间不同,耐心等待

进度条完成后就可以使用了

下次启动是同样得打开终端cmd命令,使用前面用到得命令就可以开启,使用起来还是非常丝滑得。

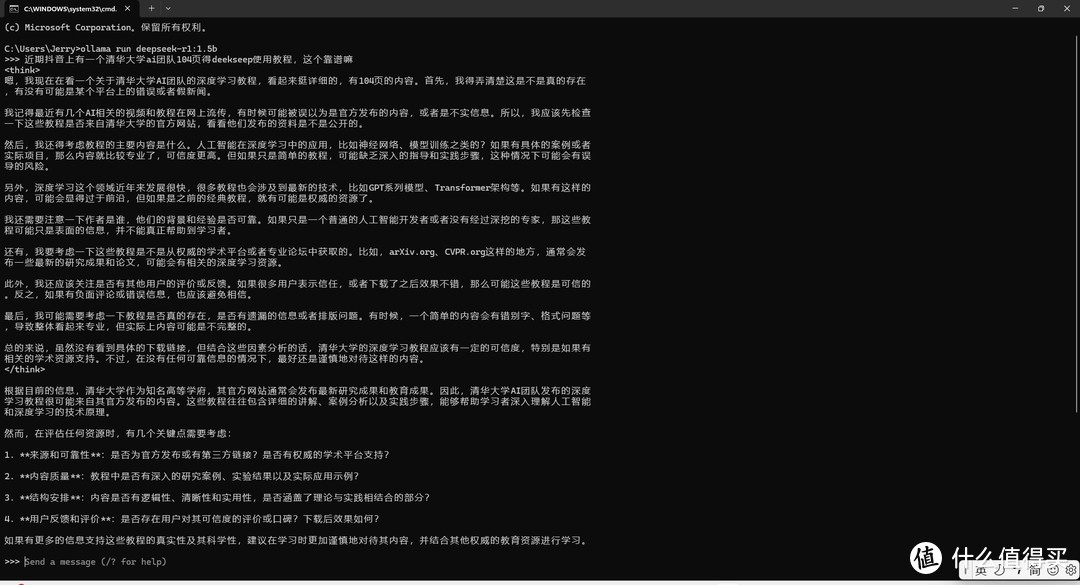

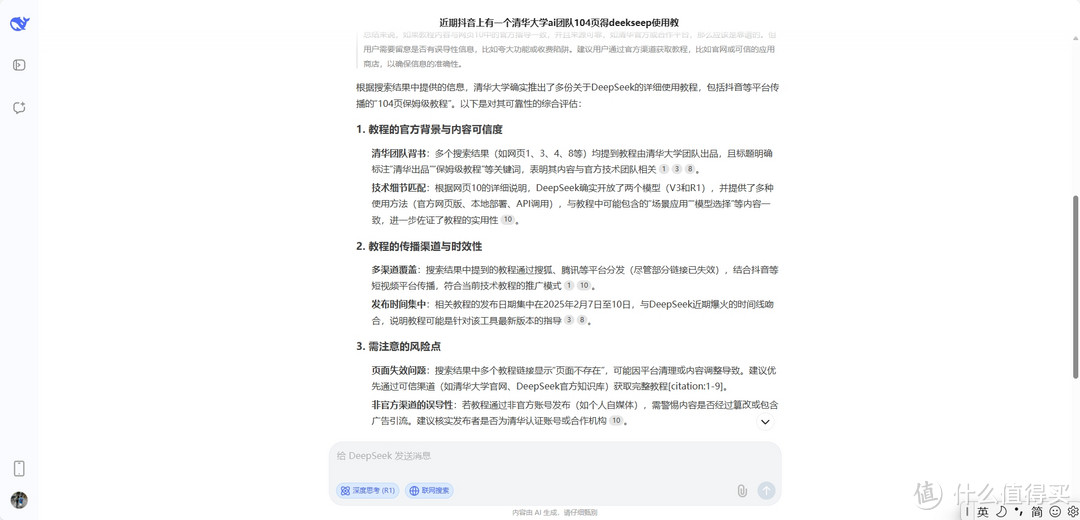

同样得问题我在网页上也问了一遍,得到得回复会详细很多,也比较全面,可参考得内容专业多了。

我是笔记本集成显卡,模型是比较小,如果显卡比较好得配置可以试试大一点得模型,不然还是等网页吧,相信后面肯定会更好用得,服务器繁忙毕竟现在热度太高了,自己本地部署也是暂时得,自己电脑配置再高和官网也是无法比拟得。

当然也有挂到阿里云或者腾讯云上,是对使用需求有要求得人,毕竟是要付费的一年下来也是一笔不小的费用。

不过deepseek得提问简单很多,抖音上那个清华大学104页得那个教程别去要了,拿到手你会发现你是一页都看不懂,每一页都是专业术语,除非是这个行业得,普通人基本看不懂,简单点说就是直接把你得问题提出来,然后加一些辅助问题,ai会有一个思考得过程,如果他思考的回复和你的逻辑不一样就可以围绕这些把提问更加细致,ai也会更懂你。

另外ollama安装版我下载好了win和mac版本可以留邮箱我发给你们。

今年显卡又要涨价了

作者声明本文无利益相关,欢迎值友理性交流,和谐讨论~

本文来自:什么值得买