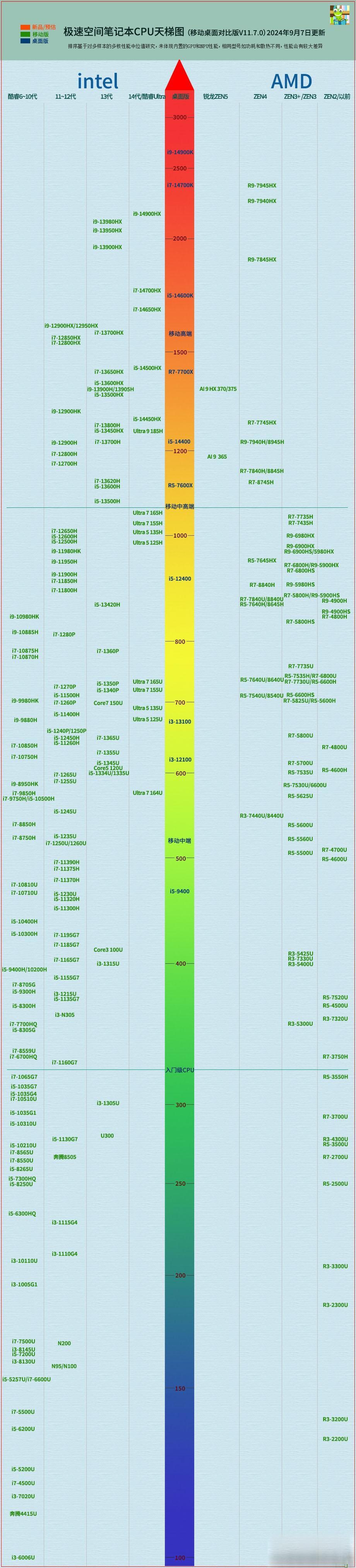

NPU,即神经网络处理单元,是一种专门设计用于加速神经网络计算的处理器。随着人工智能(AI)技术的迅猛发展,NPU在AI应用中扮演着越来越重要的角色。如今,主流的CPU,比如英特尔的酷睿Ultra和AMD的锐龙8000G系列,已经开始集成NPU模块,以应对AI时代的各种挑战。

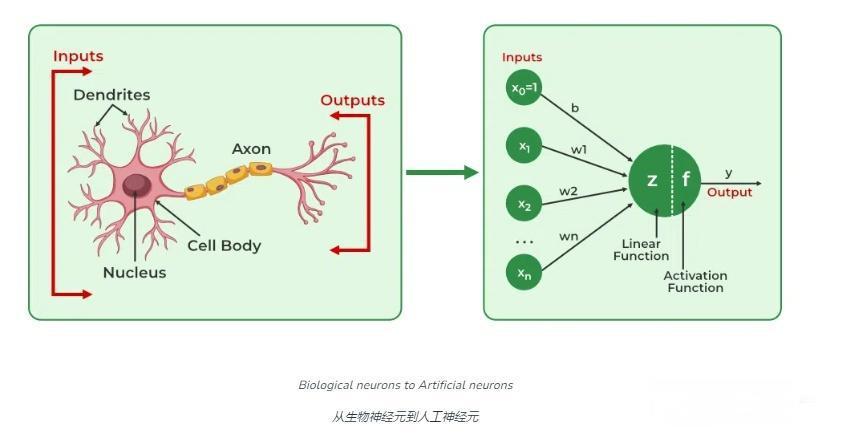

神经网络是一种模仿人脑神经元结构的计算模型,主要用于识别模式和处理复杂的数据。其由大量的节点(类似神经元)组成,这些节点通过连接(类似突触)相互作用。神经网络由输入层、隐藏层和输出层组成,每个连接都有一个权重,代表信息传递的强度。这些节点和层联合在一起,使得神经网络能够学习和存储信息,对输入数据进行分类、识别和预测。

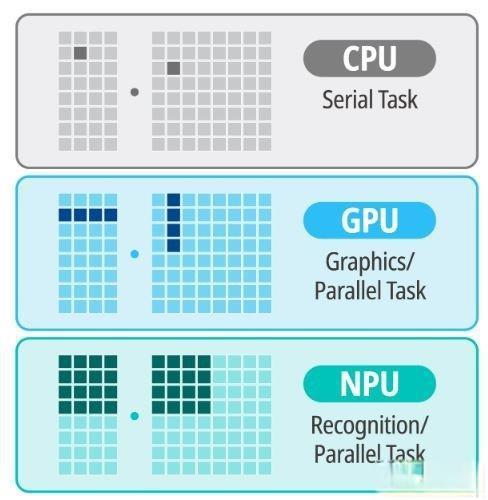

NPU的出现极大地提升了处理这些复杂计算任务的效率和性能。NPU专门设计用于快速执行神经网络计算中的关键操作,诸如矩阵乘法和卷积等,通过优化硬件层面来提升AI计算的能效。与通用处理器(CPU)和图形处理单元(GPU)相比,NPU在性能和能效方面具有显著优势;CPU具有广泛的计算任务执行能力,但在AI计算方面效率较低;GPU擅长并行计算,但并非专门为AI计算设计,在处理某些AI任务时可能不如NPU高效。

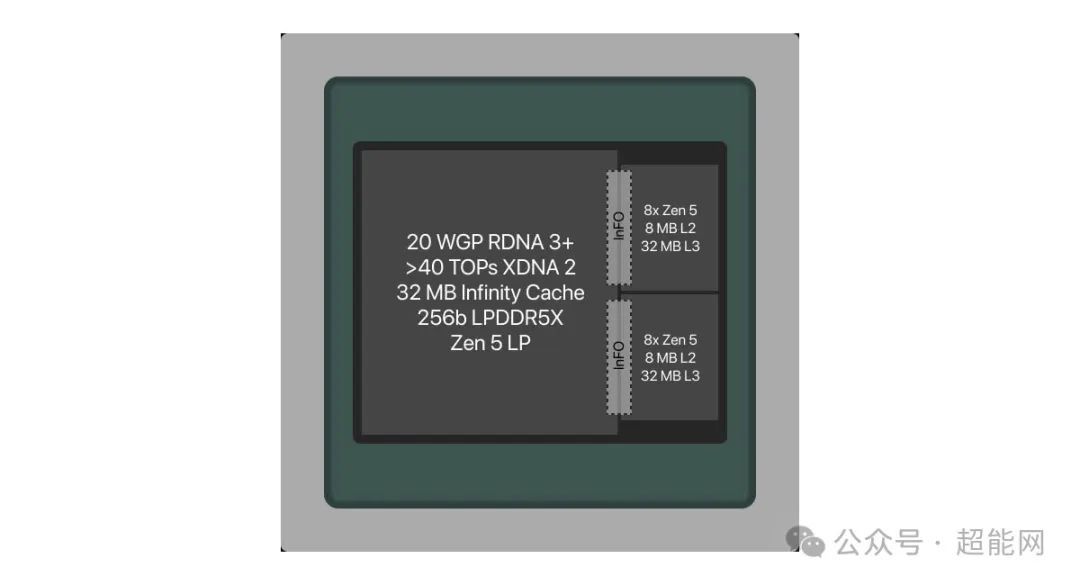

NPU的硬件架构通常包括大量的专用计算单元,以处理神经网络中的各种数学运算。例如,华为的昇腾NPU采用了达芬奇架构,集成了大量的AI核心,可以高效地处理AI训练和推理任务。这些AI核心能够高效执行矩阵乘加运算,并支持大量矩阵计算子电路,每一条指令都可以并行完成多个矩阵元素的计算。

NPU的优势还在于其高效能、低能耗以及面积效率。NPU在执行AI任务时,通常比CPU和GPU更加节能,设计紧凑,能够在有限的空间内提供高效的计算能力。此外,NPU通常包含专门的硬件加速器,如张量加速器和卷积加速器,这些加速器能够显著提高AI任务的处理速度。通过在CPU中集成NPU模块,计算系统能够更大限度地解放CPU和GPU的负担,实现各司其职。

异构计算架构也是提升NPU性能的重要手段。华为的异构计算架构CANN(Compute Architecture for Neural Networks),就是一个针对AI场景推出的异构计算架构,向上支持多种AI框架,包括MindSpore、PyTorch、TensorFlow等,向下服务AI处理器与编程。这样一种架构不仅能提高AI处理器的计算效率,还能支持用户快速构建基于昇腾平台的AI应用和业务。

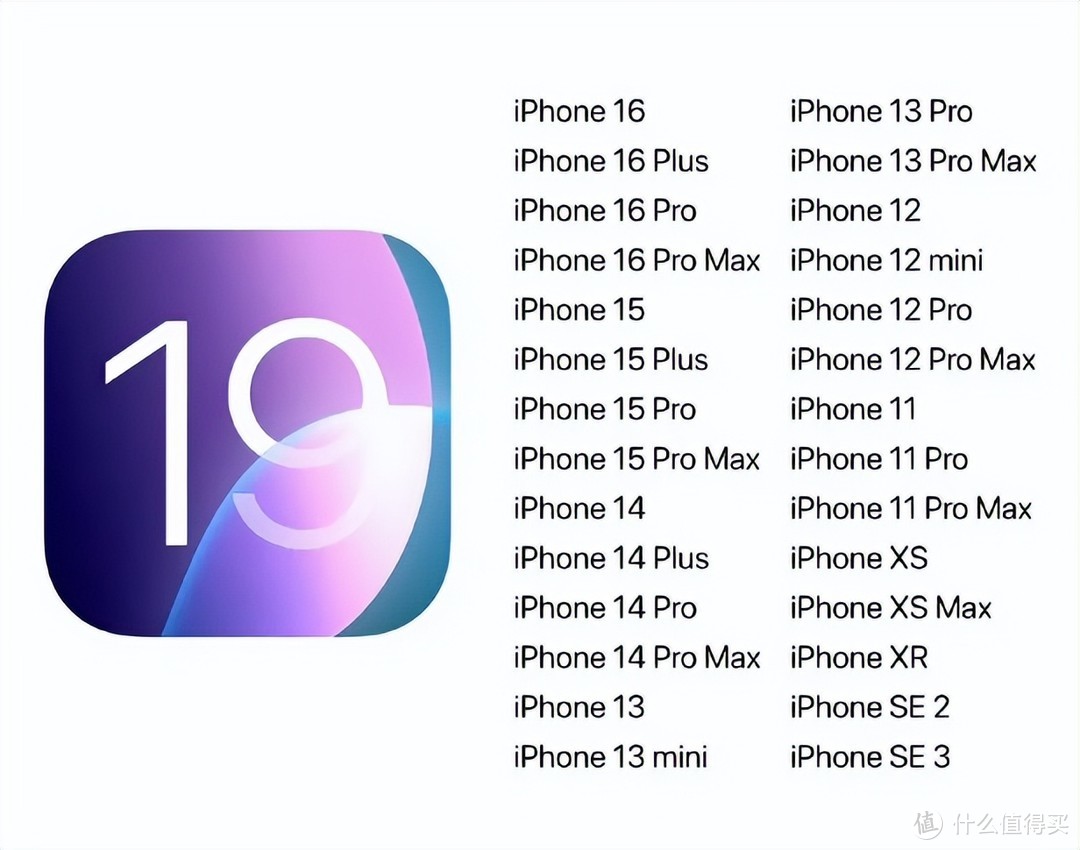

NPU的引入在各个领域展现出强大的应用潜力。在智能手机、自动驾驶汽车和智能家居等领域,NPU可以提供更加实时和高效的AI处理能力。例如,华为Mate系列手机集成了昇腾NPU,显著提升了图像识别和语音处理等AI任务的性能。同样地,特斯拉的DOJO AI芯片也利用了NPU技术,以加速自动驾驶系统的训练和推理任务。

AI芯片(如NPU)的兴起,对于AI应用的普及和推进具有重要意义。AI芯片大致可分为训练芯片和推理芯片。训练芯片用于神经网络的训练过程,需要高吞吐量的计算能力;推理芯片则用于模型部署和执行,更强调低功耗和实时性。专用AI芯片通过在硬件层面优化深度学习算法所需的矩阵乘法、卷积等关键运算,可以显著加速AI应用的执行速度,降低功耗。

此外,传统的云端推理模式面临数据传输和隐私安全等挑战,因此边缘和端侧推理成为了AI应用的重要趋势。通过在边缘设备和终端设备上部署AI芯片和模型,可以减少数据传输的延迟和带宽压力,提高AI应用的实时性和安全性。这进一步展示了NPU在处理计算密集型任务时的重要性。

NPU作为AI时代的核心技术之一,从硬件层面上极大地优化了AI计算的性能和效率。通过专门设计,NPU将复杂的计算任务高效处理,为各种AI应用提供了强大的支持。随着NPU技术的不断进步和优化,未来的AI应用将更加智能、高效和广泛普及,为各行各业带来深远的影响。

本文来自:什么值得买